qq:800819103

在线客服,实时响应

联系方式:

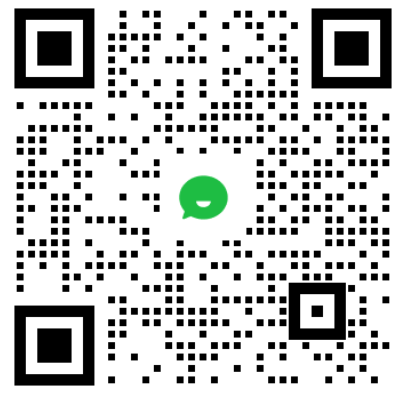

13318873961 微信客服

微信客服

微信公众号

微信公众号

爬虫用代理IP以后为何还碰到难题?许多朋友们在使用了优质稳定代理IP、控制了访问速度和次数、设定了UserAgent、Referer等一连串方法的状况下,发现爬虫工作还是会碰到各类不好的状况,造成爬虫工作一直不那麼顺利的进行,不能高效的爬取大量数据,准时完成每天的工作任务,问题出在哪里呢,有什么好的解决办法呢?

每一个网站反扒策略不同,因此需要具体问题具体分析。但是一些基本的操作依然要做好的,如下所示几点:

第一,使用高质量的爬虫代理IP

第二,设定好header信息,不仅仅是UserAgent、Referer这两个,以及许多其他的header值,都可以在浏览器中打开开发者模式(按F12)并浏览网址查看;

第三,处理好Cookie,把Cookies信息储存出来,之后再下次请求时带上Cookie;

第四,假如根据header和cookie还不能爬到数据,那么可以考虑模拟浏览器采集,常见的技术是PhantomJS;

根据上述四步,再加上51代理基本上不会爬不到数据了。